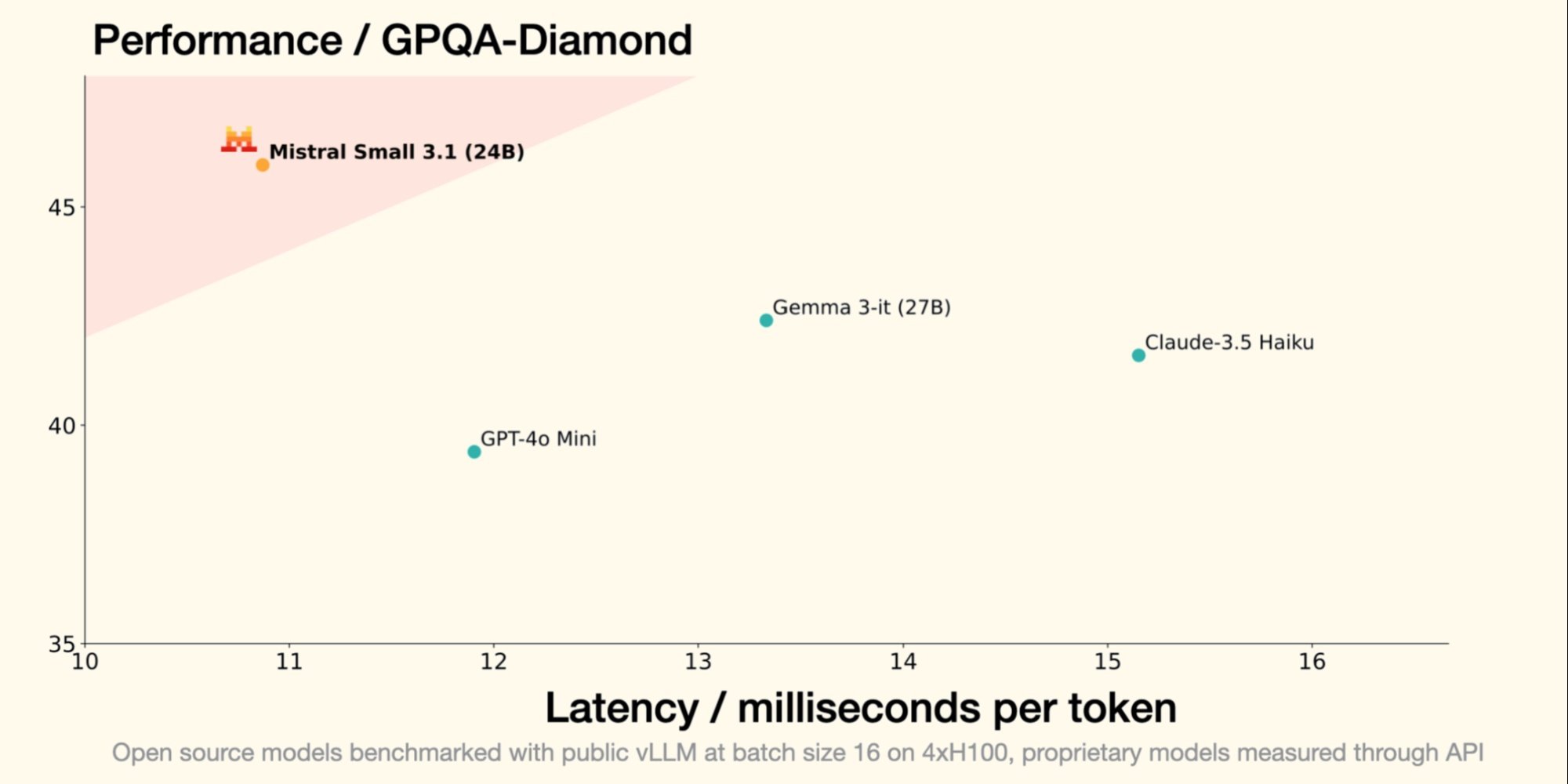

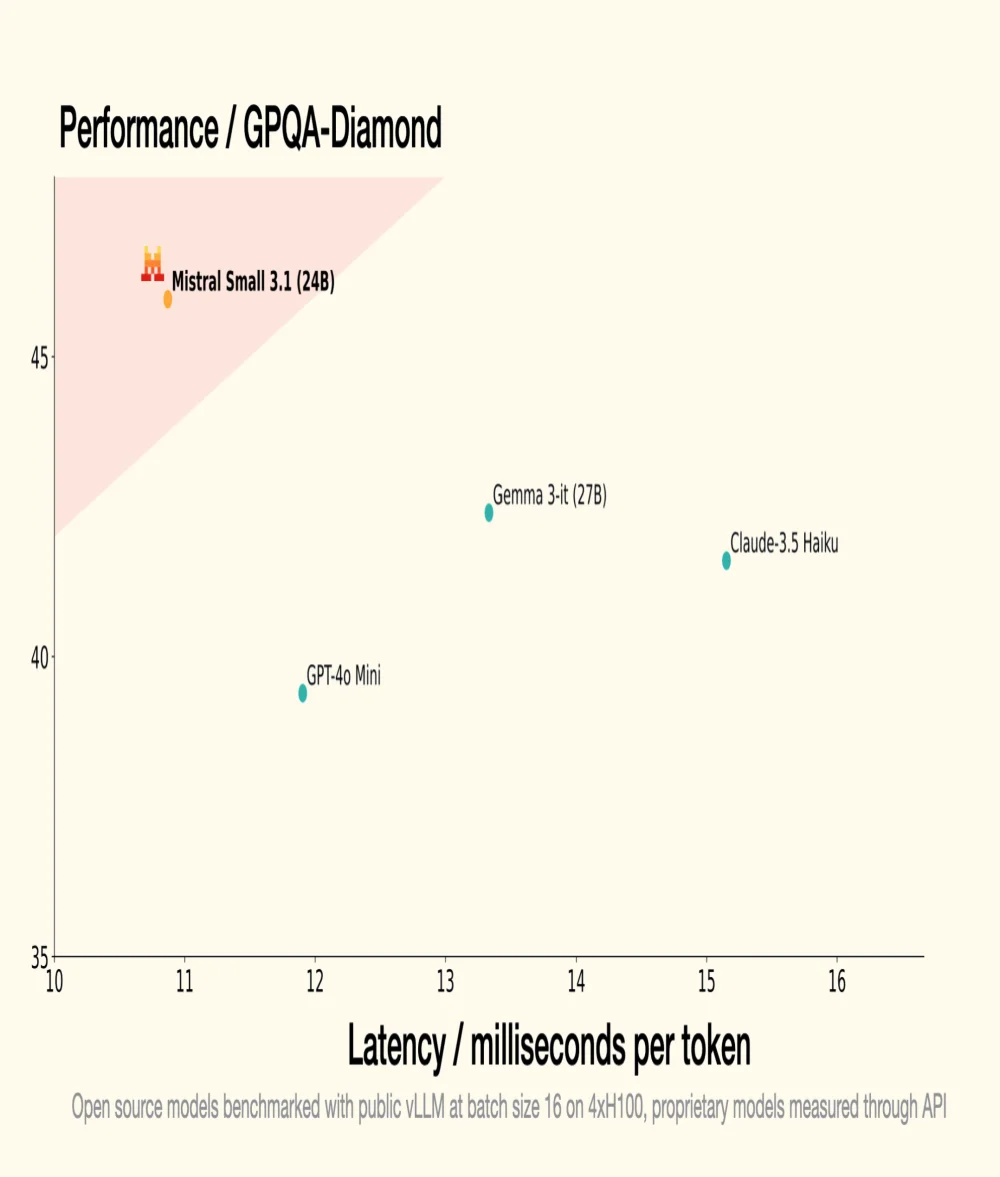

No dia 30 de janeiro, a Mistral AI, unicórnio francês da GenAI, introduziu o Small 3, um LLM com 24 bilhões de parâmetros, demonstrando que para ser eficiente, um LLM não requer um número astronômico de parâmetros. O Small 3.1, seu sucessor, mantém uma arquitetura compacta enquanto introduz melhorias significativas em termos de desempenho, compreensão multimodal e gestão de contextos longos, superando modelos como o Gemma 3-it 27B da Google e o GPT-4o Mini da OpenAI.

Fonte: Mistral AI

Otimização de Desempenho

- Uma versão instruída, Mistral Small 3.1 Instruct, pronta para ser utilizada em tarefas conversacionais e de compreensão de linguagem;

- Uma versão pré-treinada, Mistral Small 3.1 Base, ideal para fine-tuning e especialização em domínios específicos (saúde, finanças, jurídico, etc.).

- Small 3.1 Instruct apresenta melhor desempenho que o Gemma 3-it (27B) da Google em tarefas textuais, multimodais e multilíngues;

- Supera o GPT-4o Mini da OpenAI em benchmarks como MMLU, HumanEval e LongBench v2, especialmente graças à sua janela contextual estendida para 128.000 tokens;

- Também supera o Claude-3.5 Haiku em tarefas complexas que envolvem contextos longos e dados multimodais;

- Destaca-se em relação ao Cohere Aya-Vision (32B) em benchmarks multimodais como ChartQA e DocVQA, demonstrando uma compreensão avançada dos dados visuais e textuais;

- Small 3.1 exibe alto desempenho em multilinguismo, superando seus concorrentes em categorias como línguas europeias e asiáticas.

Para entender melhor

O que é um LLM (Large Language Model) em termos de tecnologia e funcionamento?

Um LLM é um modelo de inteligência artificial projetado para entender e gerar linguagem natural. Ele é composto por bilhões de parâmetros ajustados através do treinamento em grandes quantidades de texto para prever a próxima palavra em uma frase. Os LLMs são usados em aplicações como tradução automática, resumo de texto e agentes conversacionais.

O que é a licença Apache 2.0 e por que é importante para projetos de código aberto?

A licença Apache 2.0 é uma licença de software de código aberto que permite aos usuários fazer modificações significativas e usar o software para fins comerciais ou privados, enquanto concede patentes. É importante porque garante que as contribuições permaneçam gratuitas e acessíveis, promovendo a inovação e a adoção de novas tecnologias.