Podsumowanie

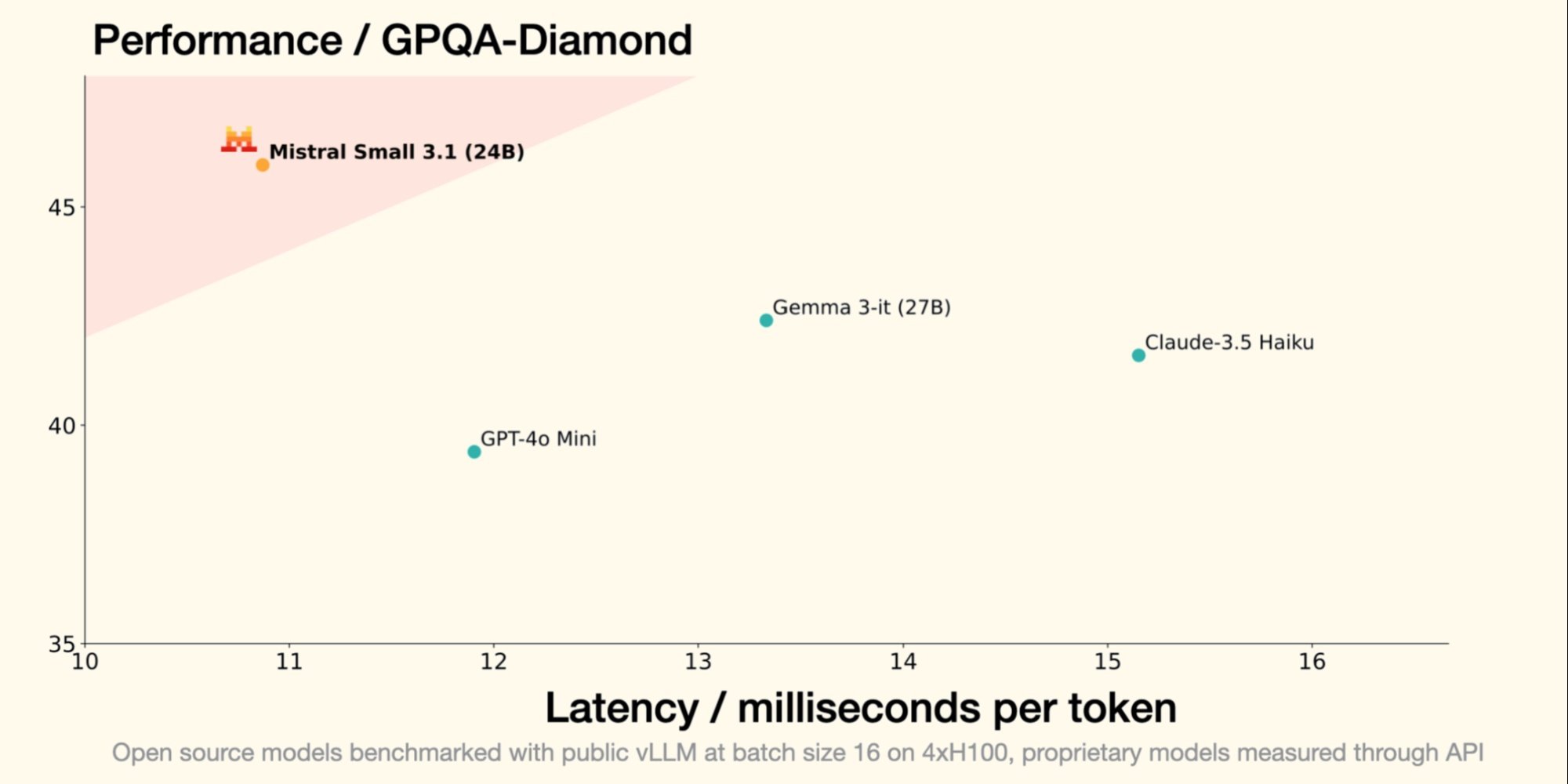

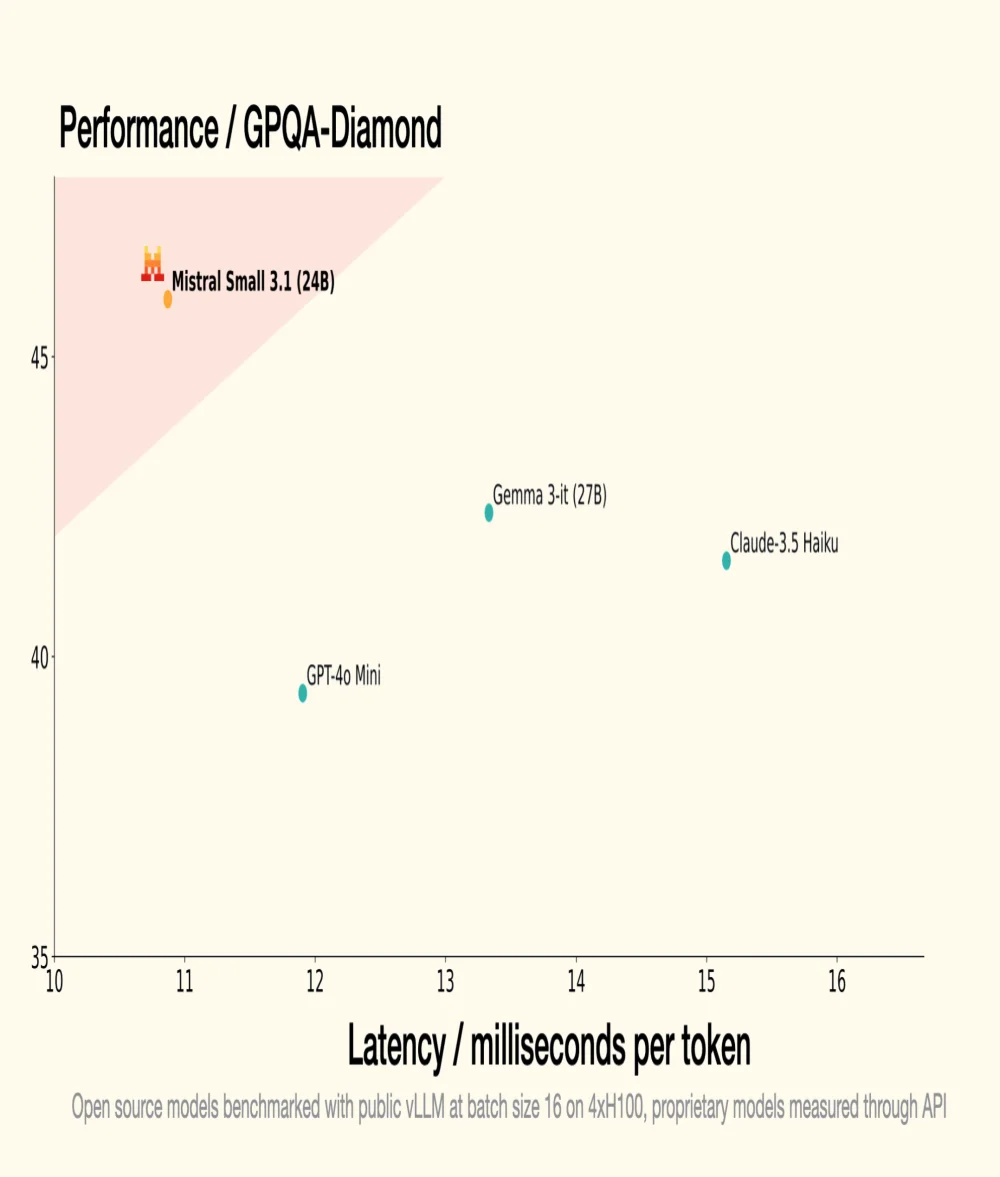

30 stycznia Mistral AI, francuski jednorożec w dziedzinie GenAI, wprowadził Small 3, LLM o 24 miliardach parametrów, udowadniając, że aby być wydajnym, LLM nie wymaga astronomicznej liczby parametrów. Jego następca, Small 3.1, zachowuje kompaktową architekturę, wprowadzając jednocześnie znaczące ulepszenia w zakresie wydajności, zrozumienia multimodalnego i zarządzania długimi kontekstami, przewyższając modele takie jak Gemma 3-it 27B od Google i GPT-4o Mini od OpenAI.

Źródło: Mistral AI

Optymalizacja wydajności

- Wersja instruowana, Mistral Small 3.1 Instruct, gotowa do użycia w zadaniach konwersacyjnych i zrozumienia języka;

- Wersja wstępnie wytrenowana, Mistral Small 3.1 Base, idealna do fine-tuningu i specjalizacji w określonych dziedzinach (zdrowie, finanse, prawo itp.).

- Small 3.1 Instruct wykazuje lepszą wydajność niż Gemma 3-it (27B) od Google w zadaniach tekstowych, multimodalnych i wielojęzycznych;

- Przewyższa GPT-4o Mini od OpenAI w benchmarkach takich jak MMLU, HumanEval i LongBench v2, szczególnie dzięki rozszerzonemu oknu kontekstowemu do 128 000 tokenów;

- Przewyższa także Claude-3.5 Haiku w złożonych zadaniach obejmujących długie konteksty i dane multimodalne;

- Przewyższa Cohere Aya-Vision (32B) w benchmarkach multimodalnych takich jak ChartQA i DocVQA, wykazując zaawansowane zrozumienie danych wizualnych i tekstowych;

- Small 3.1 wykazuje wysoką wydajność w wielojęzyczności, przewyższając swoich konkurentów w kategoriach takich jak języki europejskie i azjatyckie.

Bardziej zrozumiałe

Czym jest LLM (duży model językowy) pod względem technologii i funkcjonowania?

LLM to model sztucznej inteligencji zaprojektowany do rozumienia i generowania języka naturalnego. Składa się z miliardów parametrów dostosowywanych poprzez trenowanie na dużych zbiorach tekstu w celu przewidywania następnego słowa w zdaniu. LLM-y są wykorzystywane w aplikacjach takich jak automatyczne tłumaczenie, podsumowanie tekstu i agenci konwersacyjni.

Co to jest licencja Apache 2.0 i dlaczego jest ważna dla projektów open source?

Licencja Apache 2.0 to licencja na oprogramowanie open source, która pozwala użytkownikom dokonywać znacznych modyfikacji i używać oprogramowania do celów komercyjnych lub prywatnych, przyznając jednocześnie patenty. Jest ważna, ponieważ zapewnia, że wkłady pozostają bezpłatne i dostępne, wspierając innowacje i przyjmowanie nowych technologii.