La unicornio canadiense Cohere ha presentado recientemente “Command A”, la última versión de su modelo insignia. Diseñado específicamente, al igual que sus predecesores, para satisfacer las necesidades de las empresas, este LLM de 111 mil millones de parámetros, que combina rendimiento y eficiencia energética, compite con modelos de primer nivel como GPT-4o y DeepSeek-V3.

Uno de los principales puntos fuertes de Command A para las empresas es su huella material mínima. Mientras que la mayoría de los modelos comparables requieren hasta 32 GPU, Command A funciona eficientemente con solo dos GPU A100 o H100, lo que resulta en una reducción significativa de costos y latencia, así como una mayor velocidad de ejecución. Además de una generación más rápida del primer token, puede generar hasta 156 tokens/s, lo que representa un rendimiento 1.75 veces superior a GPT-4o y 2.4 veces superior a DeepSeek-V3.

Rendimiento de Command A

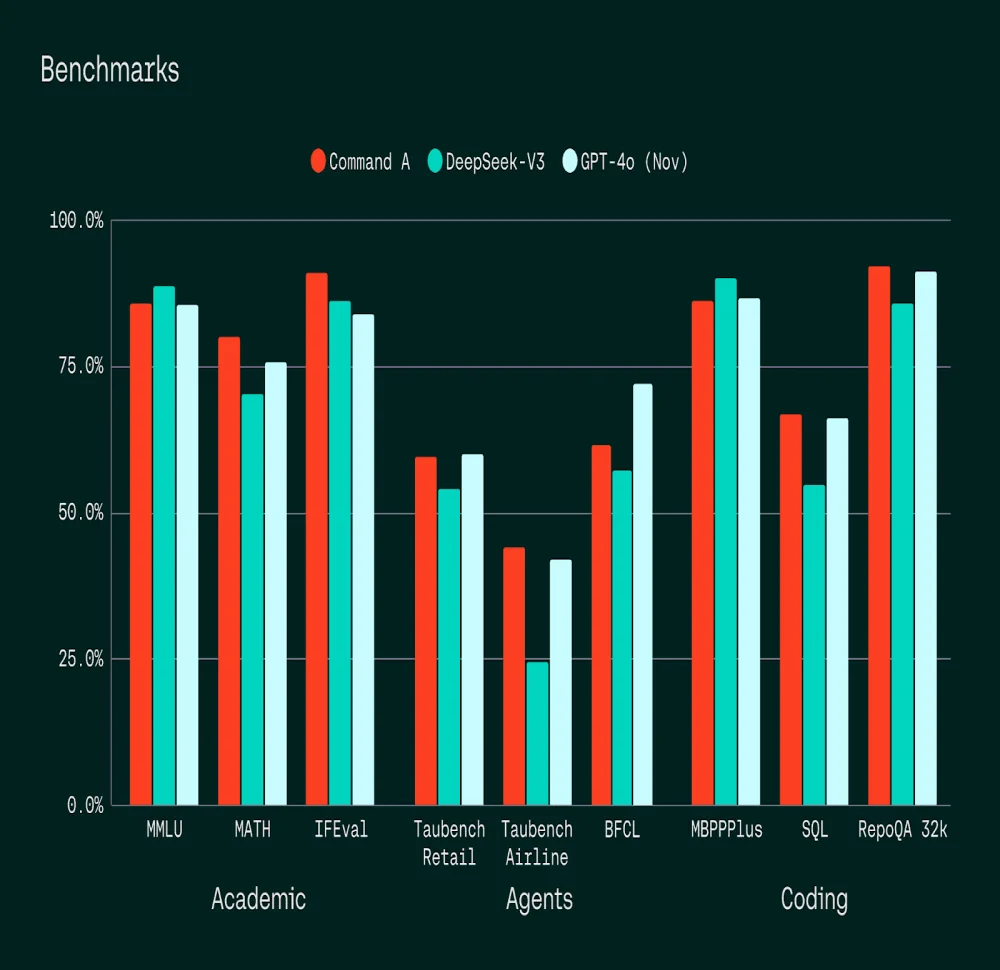

Cohere ha evaluado el rendimiento de Command A en comparación con GPT-4o y DeepSeek-V3 en benchmarks académicos: MMLU (conocimientos generales), MATH, IFEval (seguimiento de instrucciones), pruebas de agentes inteligentes (BFCL, Taubench) y benchmarks de codificación (MBPPPlus, SQL, RepoQA).

Sus capacidades en seguimiento de instrucciones, codificación, especialmente en SQL, y en tareas de agentes superan a las de sus competidores.

En pruebas de evaluación humana, Command A, que cubre 23 de los principales idiomas, ha superado a sus competidores en varios idiomas, especialmente en árabe dialectal, donde se ha mostrado más coherente y preciso que GPT-4o y DeepSeek-V3. Esta capacidad para adaptarse a contextos locales representa una ventaja estratégica para las empresas que operan a nivel internacional.

Capacidades optimizadas para empresas

A diferencia de su predecesor, que soportaba una longitud de contexto de 128,000 tokens, Command A cuenta con una longitud de contexto de 256 tokens, lo que lo hace apto para analizar documentos empresariales extensos. Integra funcionalidades avanzadas como la generación aumentada por recuperación (RAG) con citas verificables y el uso de herramientas de agentes seguros.

Es particularmente eficaz para:

Gracias a una integración fluida con North, la plataforma de agentes IA de

Cohere, Command A permite a las empresas desarrollar soluciones de IA a medida manteniendo un alto nivel de seguridad y cumplimiento.

Disponibilidad y precios

Ya disponible en la plataforma

Cohere, con un soporte próximo por parte de los principales proveedores de nube, Command A se ofrece a un costo de 2.50 $ por 1 millón de tokens de entrada y 10.00 $ por 1 millón de tokens de salida. También está accesible para fines de investigación en

Hugging Face.

Para entender mejor

¿Qué es un LLM y por qué es importante para las empresas?

Un LLM (Modelo de Lenguaje Amplio) es un modelo de inteligencia artificial que utiliza grandes cantidades de datos para comprender, generar y manipular el lenguaje natural. Para las empresas, esto puede transformar las operaciones al optimizar el servicio al cliente, analizar datos complejos y mejorar la comunicación y toma de decisiones.

¿Cómo mejora la Generación Aumentada por Recuperación (RAG) las capacidades de un LLM como Command A?

RAG, o Generación Aumentada por Recuperación, permite que un LLM enriquezca sus respuestas con datos actuales y relevantes externos al modelo. Esto se logra consultando bases de datos o documentos externos, verificando la información proporcionada y aumentando la precisión y relevancia de los resultados generados.