在1月30日,法国GenAI独角兽Mistral AI推出了Small 3,这是一款拥有240亿参数的LLM,展示了LLM要想高效并不需要天文数字的参数。其继任者Small 3.1保留了紧凑的架构,同时在性能、多模态理解和长文本情境管理方面进行了显著改进,从而超越了Google的Gemma 3-it 27B和OpenAI的GPT-4o Mini等模型。

与其前身一样,Small 3.1拥有240亿参数,可以部署在易于获取的硬件配置上,如配备单个GPU RTX 4090的PC或具有32GB RAM的Mac上,这使得企业可以在不依赖集中式云基础设施的情况下控制其敏感数据。推理速度与之前相同:每秒150个token,确保了需要即时响应的应用程序的最小延迟。秉承其对开源的承诺,Mistral AI将这两个模型以Apache 2.0许可证提供给社区,以便其使用、微调和部署于多种使用场景。

来源:Mistral AI

性能优化

虽然Small 3.1基于Small 3,但其主要进步之一在于将上下文窗口从32000个token扩展到128000个token,这对于涉及长文本序列推理的任务至关重要。尽管Mistral Small 3主要关注文本,3.1版本改善了对图像和文档的解读,这使其在小型专有模型中占据有利地位,并开辟了从工业质量控制到文档识别再到医学图像自动分析等多种应用的可能。

Mistral Small 3.1有两种格式可供选择:

- 一种是指令版本,Mistral Small 3.1 Instruct,适用于对话和语言理解任务;

- 另一种是预训练版本,Mistral Small 3.1 Base,适合在特定领域(如健康、金融、法律等)进行微调和专业化。

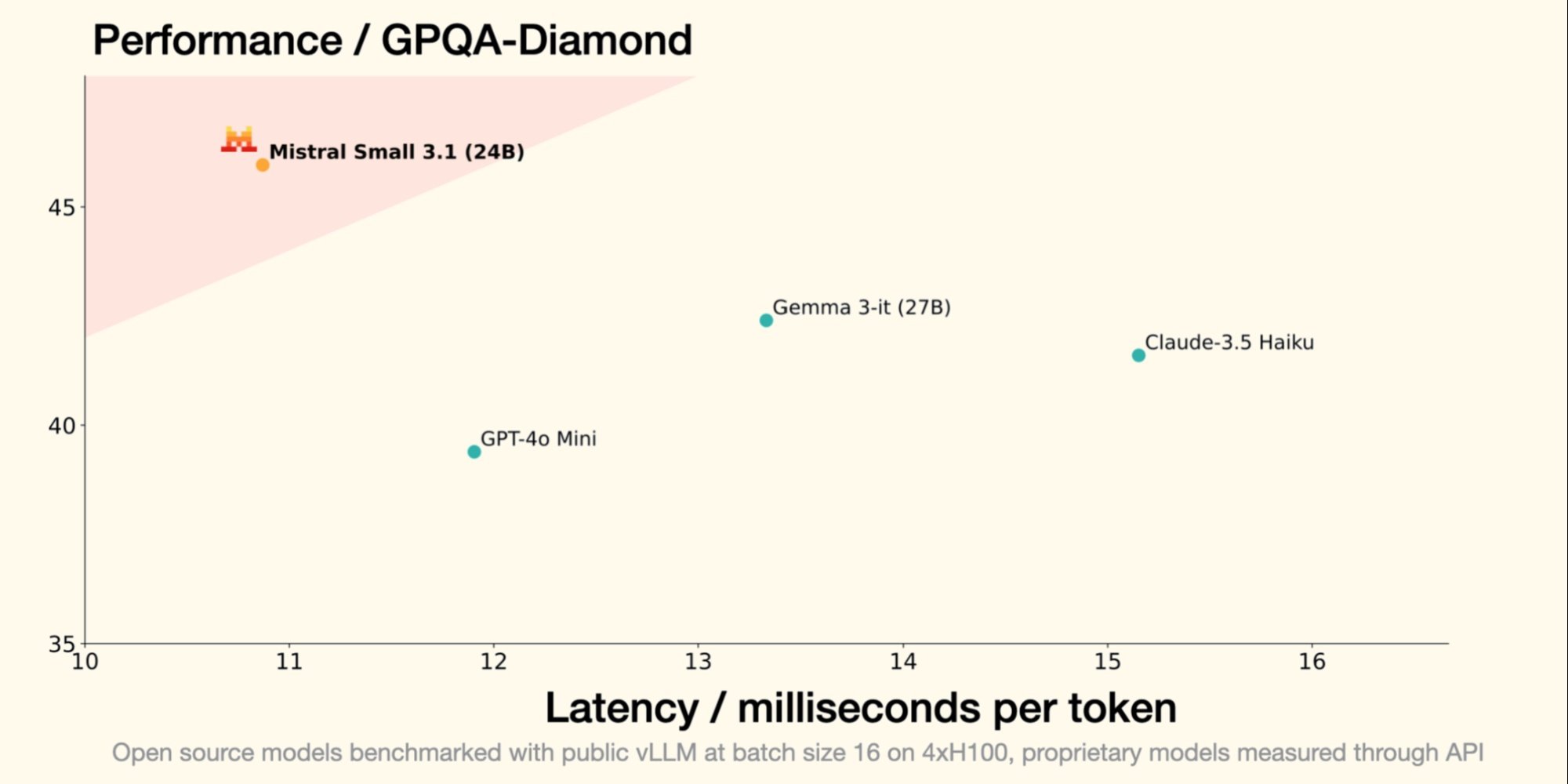

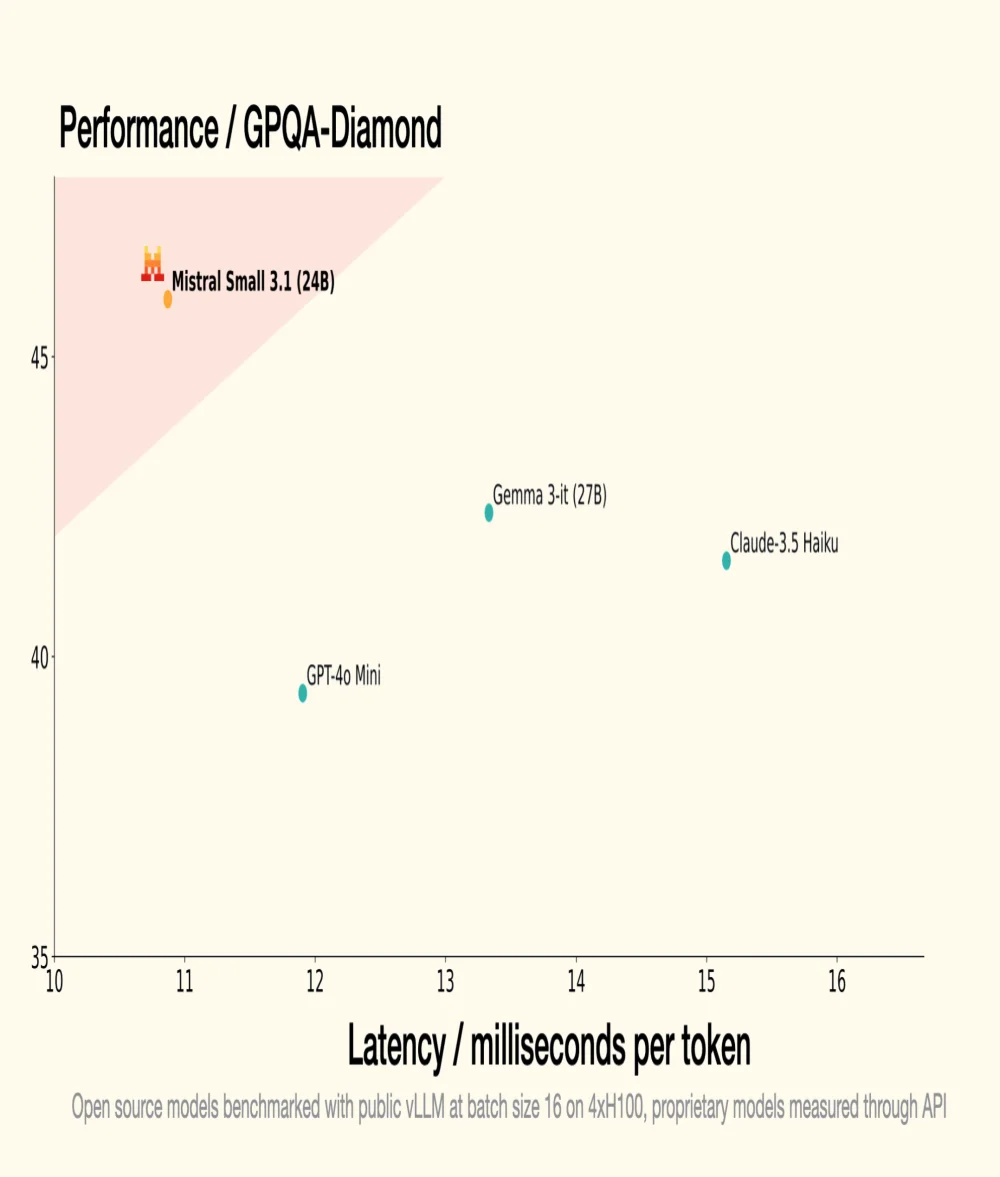

Instruct版本是其类别中最好的模型之一,在需要推理和情境理解的基准测试中超越了竞争对手。根据Mistral AI分享的基准测试:

- Small 3.1 Instruct在文本、多模态和多语言任务中表现优于Google的Gemma 3-it (27B);

- 它在诸如MMLU、HumanEval和LongBench v2等基准测试中超越了OpenAI的GPT-4o Mini,特别是由于其扩展到128000个token的上下文窗口;

- 在涉及长文本情境和多模态数据的复杂任务中,它也超越了Claude-3.5 Haiku;

- 在如ChartQA和DocVQA等多模态基准测试中,它面对Cohere Aya-Vision (32B)表现卓越,展示了对视觉和文本数据的高级理解;

- Small 3.1在多语言性能上表现出色,在欧洲和亚洲语言等类别中超过了竞争对手。

Mistral Small 3.1可以在Huggingface平台上下载,并可在Mistral AI平台上进行测试。它也在Google Cloud Vertex AI上可用,并将在未来几周内提供于NVIDIA NIM。

Pour mieux comprendre

LLM(大型语言模型)在技术和功能方面是什么?

LLM 是一种人工智能模型,旨在理解和生成自然语言。它由数十亿个参数组成,通过在大量文本上进行训练来调整,以预测句子中的下一个词。LLM 应用于自动翻译、文本摘要和对话代理等应用。

什么是 Apache 2.0 许可证,为什么它对开源项目具有重要意义?

Apache 2.0 许可证是一种开源软件许可证,允许用户进行重大修改并将软件用于商业或私人目的,同时授予专利权。它的重要性在于确保贡献始终免费且可访问,从而促进创新和新技术的采纳。